안녕하세요.

오늘 하루 Ollama를 이용한 Local LLM 구동을 체험해보고 간단한 팁과 소감을 남깁니다.

1. Ollama를 이용한 로컬 AI LLM 구동의 장점

- 개인적인 데이터를 보안 위험없이 사용할 수 있다.

- 인터넷 연결이 없어도 어디서든 사용할 수 있다.

- AI 구독비용이 발생하지 않는다.

업무를 하다보면 보안 문제로 인터넷을 사용할 수 없는 경우가 있어 로컬 LLM을 시도해 보기로 했습니다.

2. Ollama 사용법

- 많은 능력자 분들이 정말 편하게 쓸 수 있게 해두었습니다.

1) https://ollama.com/ 에 접속하여 본인의 운영체계에 맞는 프로그램만 다운 받아 설치 하면 됩니다.

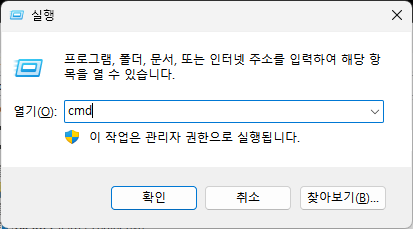

2) 설치가 끝나면 윈도우키+R 누른 후 CMD 입력

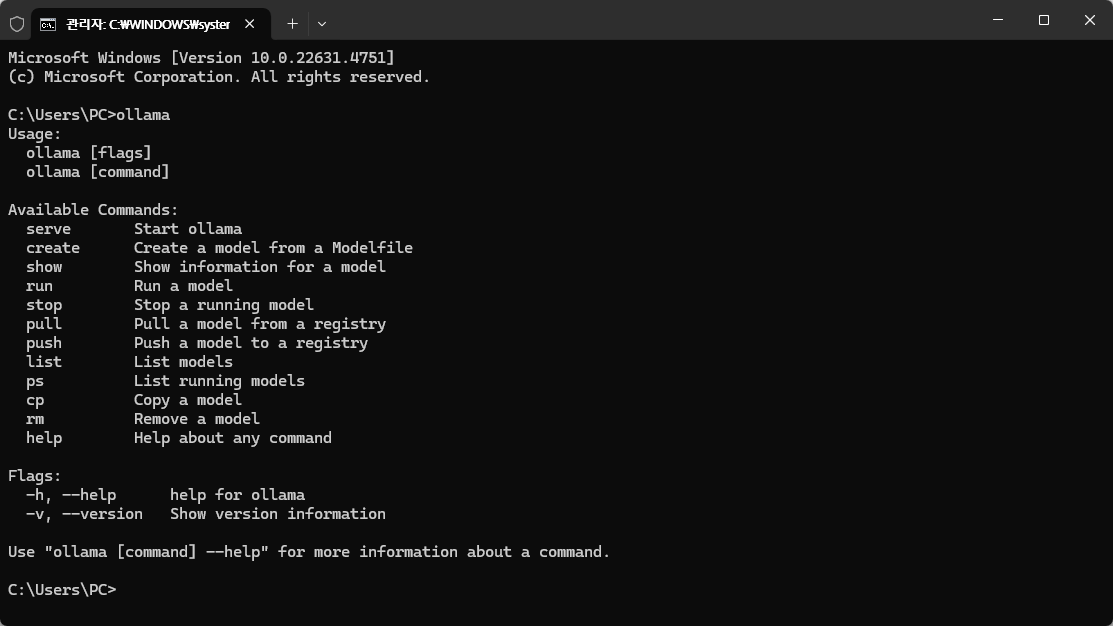

3) ollama를 입력해서 제대로 설치 되었는지 확인

4) 다시 ollama.com 홈페이지에 들어가서 상단 좌측 Models 클릭

5) 사용하기 원하는 모델 선택 후 복사 모양 아이콘 클릭

- 비디오카드 VRAM이 8GB 면 7b나 8b 정도 쓰시면 적당한것 같습니다.

- CPU로 구동해도 맛 보기 정도 가능합니다.

6) 다시 검정화면(CMD) 화면으로 돌아가서 붙여넣기(컨트롤키+V) 입력 하면 자동으로 모델 다운로드 되며 설치

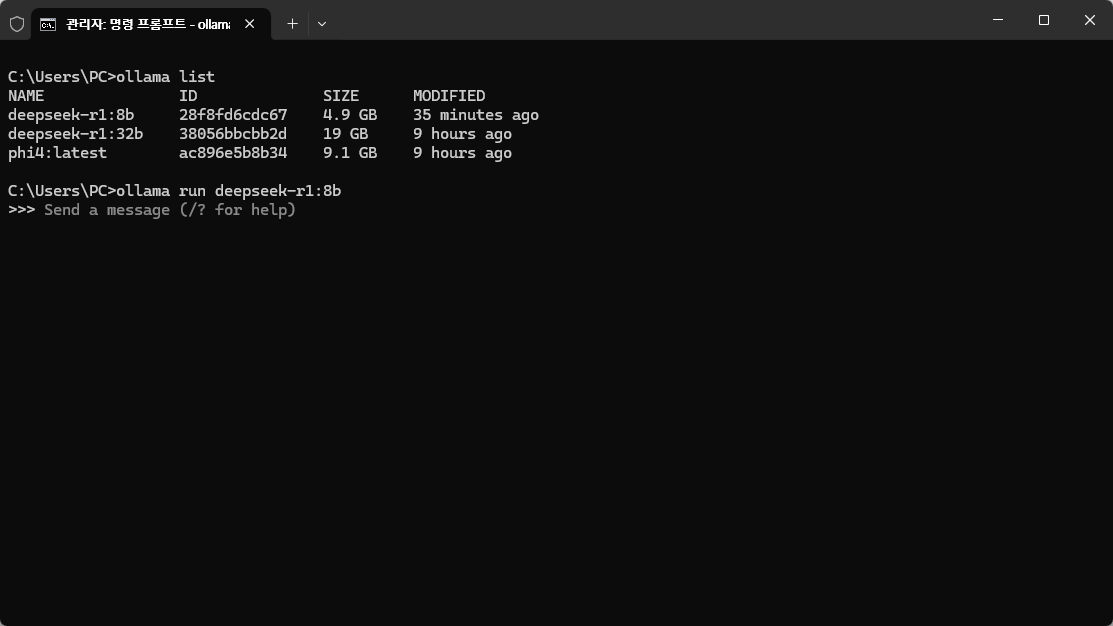

7) CMD 화면에 ollama list 치면 설치된 모델 표시됨. 이중 원하는 모델을 ollama run [모델명] 으로 실행

- 예 : >ollama run deepseek-r1:8b

8) 모델이 실행되어 원하는 내용을 입력하면 됨

3. Chat Box 사용법

- ollama 형태로 쓰면 사용이 불편하므로 웹UI 형태로 ollama를 사용하기 위해 Chat Box 사용

- https://chatboxai.app/en 방문하여 다운로드 및 설치

- 실행 후 설정(톱니바퀴) 중 모델 공급자로 ollama 선택

- chat gpt 쓰듯이 사용하면 끝

사용소감

1. 용도에 따라 간단하게 사용하는 용도라면 로컬 LLM도 활용 가능 하겠다라는 생각

2. 하지만 제대로 사용하려면 고사양 GPU가 필요하겠다라는 생각

3. 업무에 사용하기 위해 샘플 문서 올려 놓고 참조해서 원하는 결과를 찾는 수준을 위해서라면 가정용 PC로는 절대 무리

'팁과 사용기' 카테고리의 다른 글

| 재미로 알아보는 화장지 평량 리뷰 #3(크리넥스 데코&소프트) (0) | 2025.03.23 |

|---|---|

| Ollama 사용시 미지원 AMD GPU 가속 적용하는 방법(RX6600, RX580 등) (0) | 2025.01.27 |

| 아프리카 지역 방문을 위한 황열 예방주사 접종법 (6) | 2024.10.01 |

| 재미로 알아보는 화장지 평량 리뷰 #2(깨끗한 나라 순수프리미엄 녹색, 파란색 버전 vs 한예지 프리미어 울트라 소프트) 내돈내산출처 (3) | 2024.05.01 |

| 영어 문법포기자 중년의 영어공부(+OPIc 미세팁) (3) | 2024.02.24 |

댓글